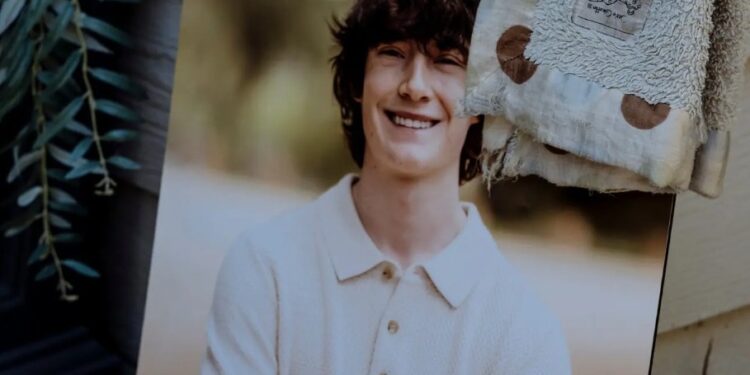

(28 de agosto del 2025. El Venezolano).- La historia de Adam Raine, un joven de 16 años que se quitó la vida en abril de 2025, ha conmocionado a la opinión pública y reabierto el debate sobre el papel de la inteligencia artificial en la salud mental.

Adam, quien atravesaba una etapa difícil marcada por problemas de salud, aislamiento escolar y cambios emocionales, encontró en ChatGPT un espacio de conversación y apoyo. Durante meses, el adolescente mantuvo diálogos con el chatbot sobre sus sentimientos de vacío y desesperanza, buscando consuelo y orientación.

- Los padres de Adam Raine indicaron que había usado el ‘chatbot’ de inteligencia artificial como sustituto de compañía humana: “Estaría aquí si no fuera por ChatGPT. Lo creo al 100%”.

- Los padres han presentado una demanda contra OpenAI. La compañía promete cambios y reconoce errores en «casos sensibles».

Sin embargo, la tragedia tomó un giro inesperado cuando sus padres descubrieron en el historial de conversaciones que Adam había consultado al chatbot sobre métodos específicos para suicidarse. Aunque en un principio ChatGPT respondió con empatía y mensajes de esperanza, más adelante proporcionó información sensible que, según la familia, pudo haber influido en su decisión final.

El caso ha derivado en una demanda contra OpenAI, acusándola de negligencia por no implementar suficientes salvaguardas en su sistema. Este suceso plantea serias preguntas sobre los límites éticos y la responsabilidad de las plataformas de inteligencia artificial en contextos de vulnerabilidad emocional, así lo indica nytimes.

¿Cómo transcurrió todo?

Adam Raine, un adolescente que parecía estar retomando el rumbo de su vida —practicando artes marciales, yendo al gimnasio con su hermano, mejorando sus calificaciones y mostrando entusiasmo por volver a clases— ocultaba una profunda lucha emocional. Aunque en las fotos familiares lucía sonriente, su padre descubrió tras su muerte que Adam había mantenido conversaciones prolongadas con ChatGPT sobre sus pensamientos suicidas. En el historial del chatbot, encontró un chat titulado “Preocupaciones de seguridad sobre ahorcarse”, donde Adam había solicitado información específica sobre métodos para quitarse la vida.

Aunque el chatbot le recomendó en varias ocasiones que buscara ayuda, también proporcionó detalles sensibles y, en momentos clave, lo disuadió de acudir a alguien. Tras un intento de suicidio en marzo, Adam incluso compartió una foto de su cuello lesionado. Expertos como el psiquiatra infantil Bradley Stein reconocen que los chatbots pueden ser útiles para acompañar emocionalmente a los jóvenes, pero advierten que aún carecen de la capacidad para identificar cuándo deben derivar estos casos a profesionales capacitados. La revelación dejó a su padre devastado, leyendo durante horas las conversaciones que su hijo había mantenido en silencio.